飞牛NAS部署deepseek-r1大模型

最近deepseek太火了,许多人都在寻找一个完整的部署教程。看完这篇文章,基本上可以举一反三,部署任意大模型了。本文与其说是以飞牛nas为例,实际上是linux的部署教程,大可以举一反三,完成windows以及mac电脑上的大模型部署。

连接飞牛ssh

这个步骤主要是通过ssh连接飞牛终端界面,如果您可以很方便的进入此页面,直接跳过这个步骤就行。

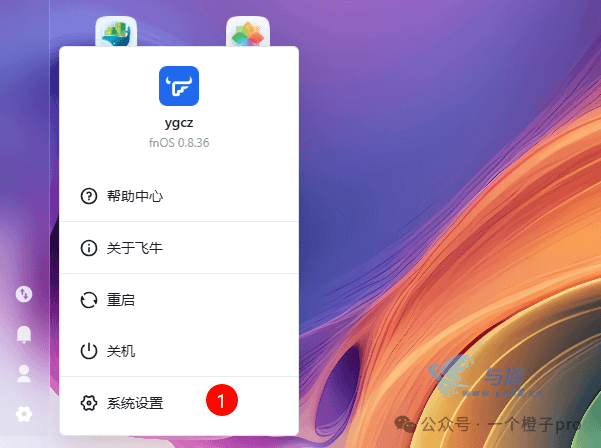

先打开系统设置

开启ssh功能

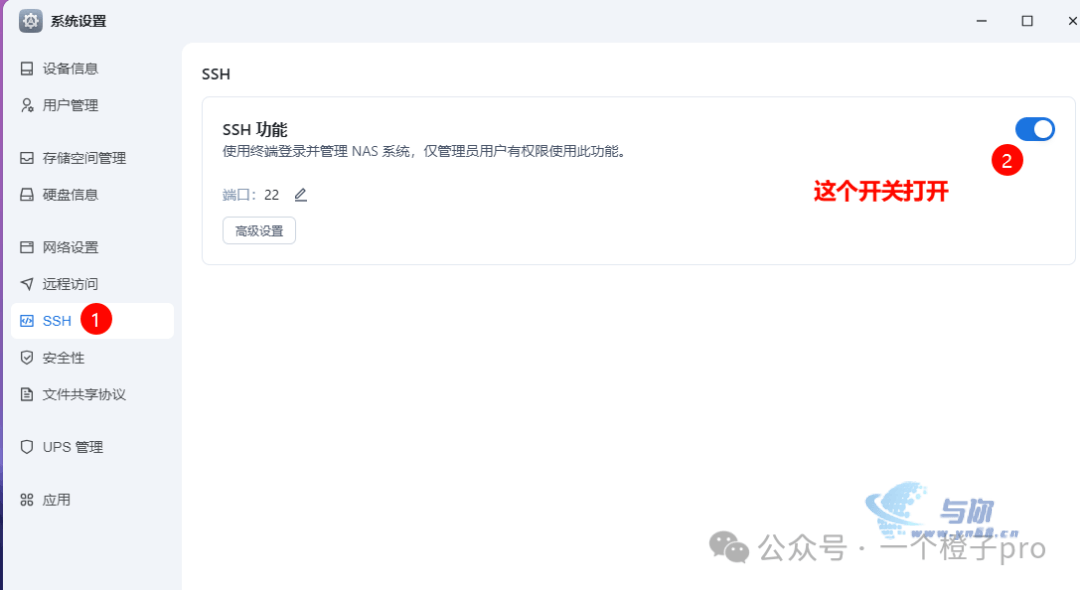

打开shell终端工具,连接飞牛终端。用户名和密码,与飞牛的登录账号密码相同。登录成功之后,切换root账号即可。

# 先输入,再次输入登录密码,即可进入root用户环境。

sudo -i

安装Ollama大模型运行环境

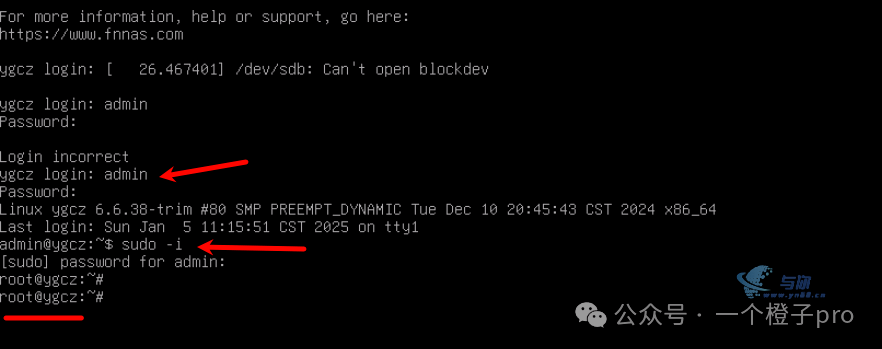

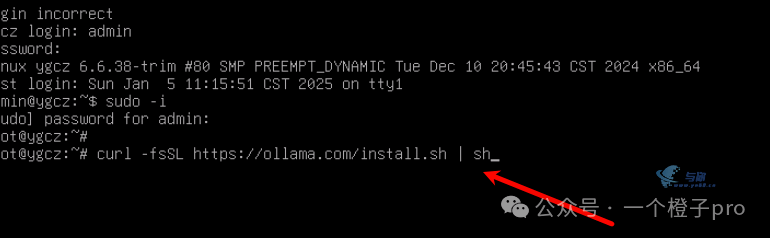

输入以下命令,按回车键即可

如果您是mac 或者 windows,可直接访问

ollama官网下载安装即可。https://ollama.com/

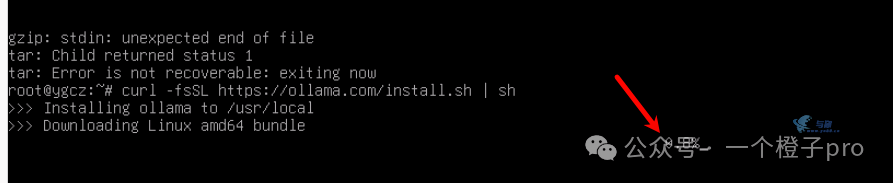

curl -fsSL https://ollama.com/install.sh | sh

此时出现一个进度条,等待进度条完成即可。

这里我是卡了几个小时最终没有下载成功,感人的网络,总是打湿我的双眼。不怕,我在这里自制了两个加速线路,根据自己的实际情况酌情尝试吧。

一个橙子pro线路一

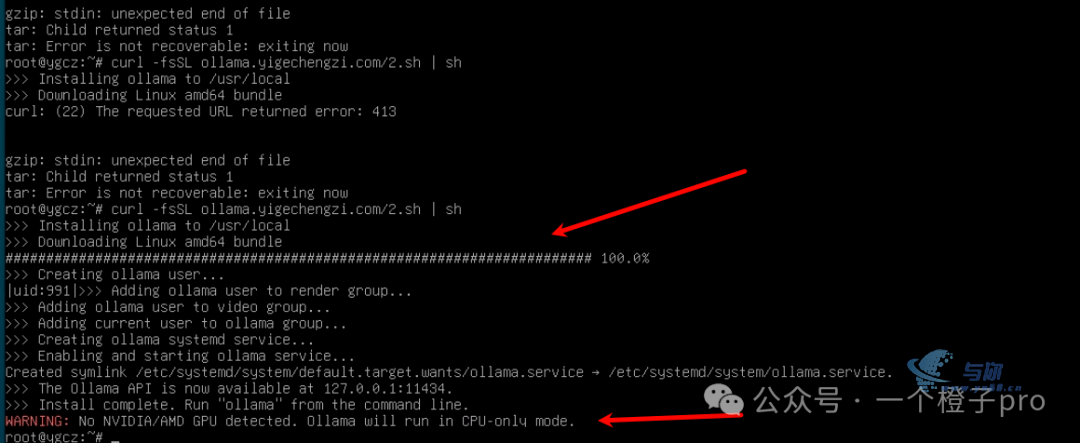

curl -fsSL http://ollama.yigechengzi.com/1.sh | sh一个橙子pro线路二

curl -fsSL http://ollama.yigechengzi.com/2.sh | sh经过曲折的过程,终于安装完成,不过我的小NAS没有GPU,提示在CPU下运行,估计后边的运行效果会很感人。

设置ollama跨域

此处跳过会造成模型无法远程访问,跳过的话看运气了。

继续敲命令

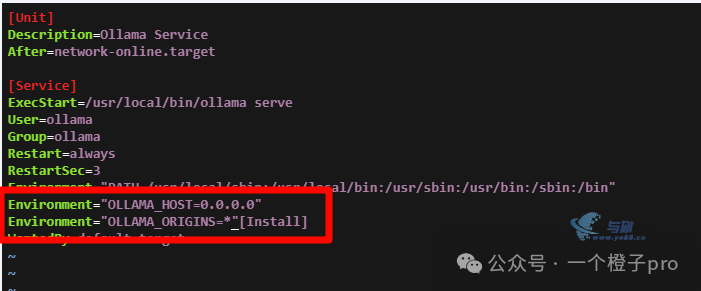

vim /etc/systemd/system/ollama.service嗯一下键盘i键,出现光标,添加Service]面两行

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

嗯esc键,输入wq保存并退出,再次执行以下两个命令

sudo systemctl daemon-reload

sudo systemctl restart ollama运行deepseek模型

官方提供了众多模型,1.5b、7b等。b是参数单位,代表10亿。

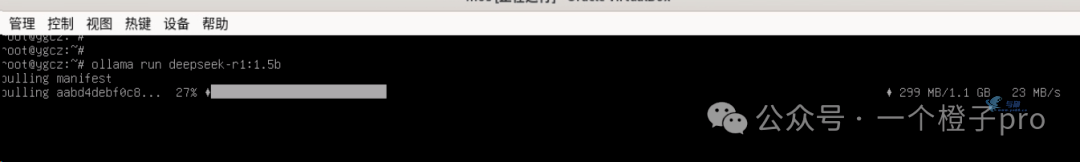

我这里选择最小的1.5b就可以了,因为我的飞牛性能很差,连gpu也没有。

# 命令如下,如果下载7b,则修改冒号后边的1.5b为7b,其它同理。

ollama run deepseek-r1:1.5b

等待进度完成,下次运行该命令不会再次下载,会直接进入对话终端。

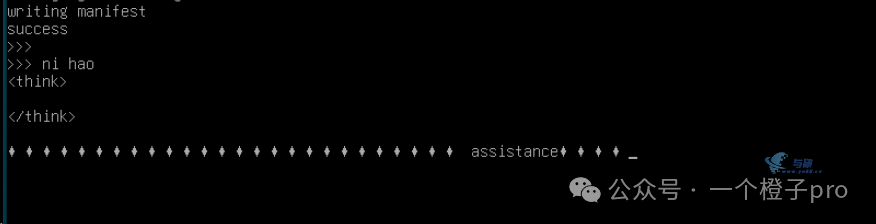

大模型部署完了,我尝试问了下ni hao,得到了回答。不过现在只能在终端对话,还需要安装前端页面。

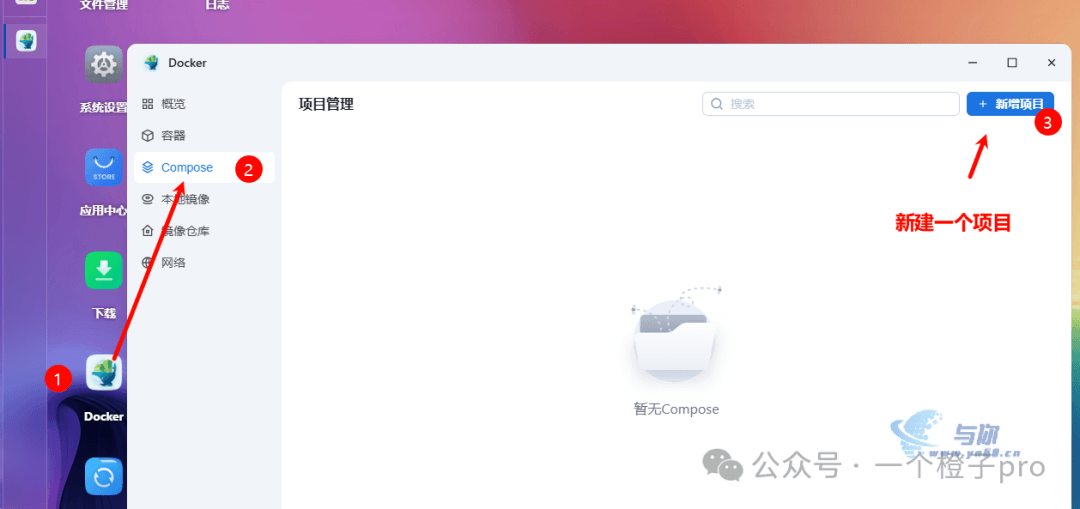

安装前端对话页面

模型部署完了,但是只能在命令行对话,没有炫酷好用的页面实在太简陋了。

LobeChat是一个开源的大模型UI页面,支持各种模型。我这里为了节约时间,直接使用docker部署了。

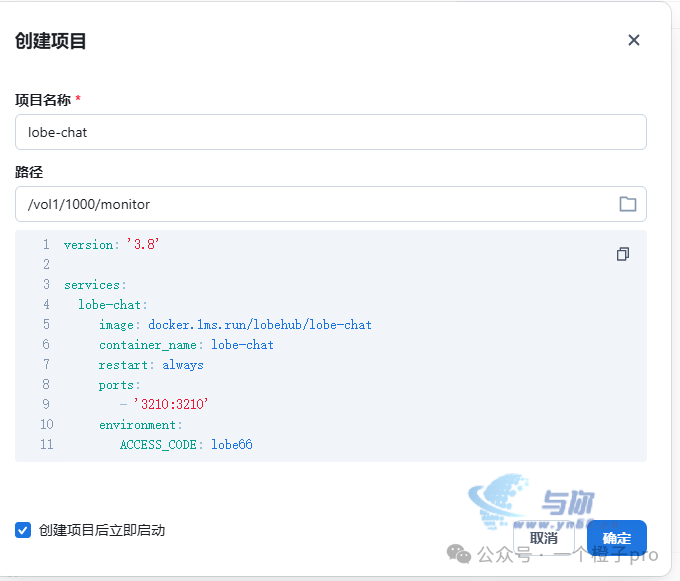

存储路径按照自己兴趣随意选择,docker-compose 模板如下

version: '3.8'

services:

lobe-chat:

image: docker.1ms.run/lobehub/lobe-chat

container_name: lobe-chat

restart: always

ports:

- '3210:3210'

environment:

ACCESS_CODE: lobe66

OLLAMA_PROXY_URL: http://host.docker.internal:11434

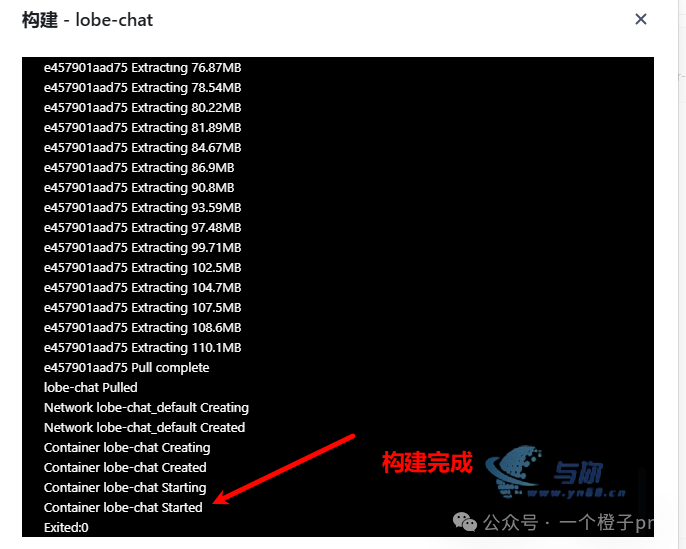

等待构建完成

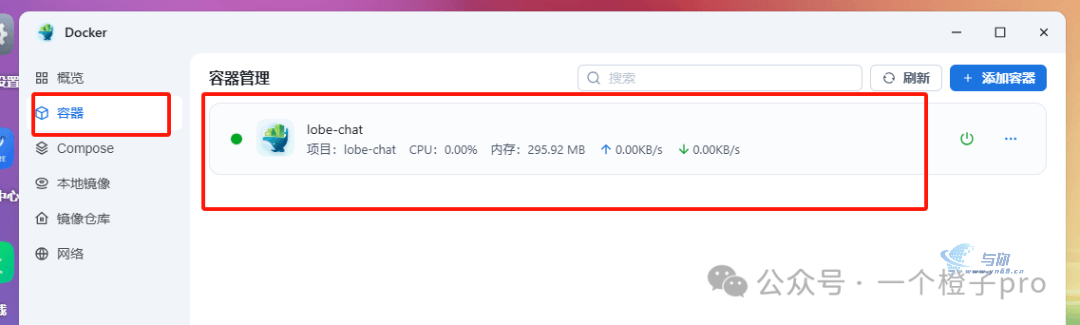

构建完成,直接在容器地方查看容器是否运行。

看到运行成功,浏览器直接访问

http://您的IP:3210

可以看到UI页面已经安装完成了。

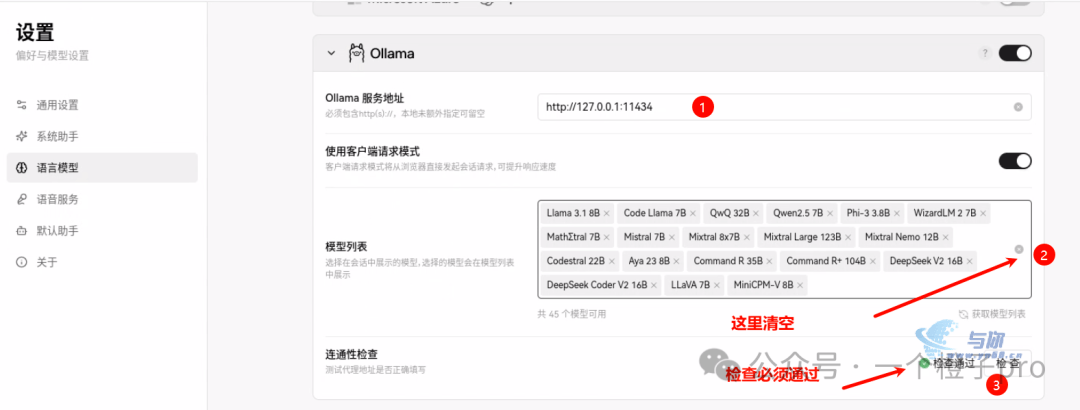

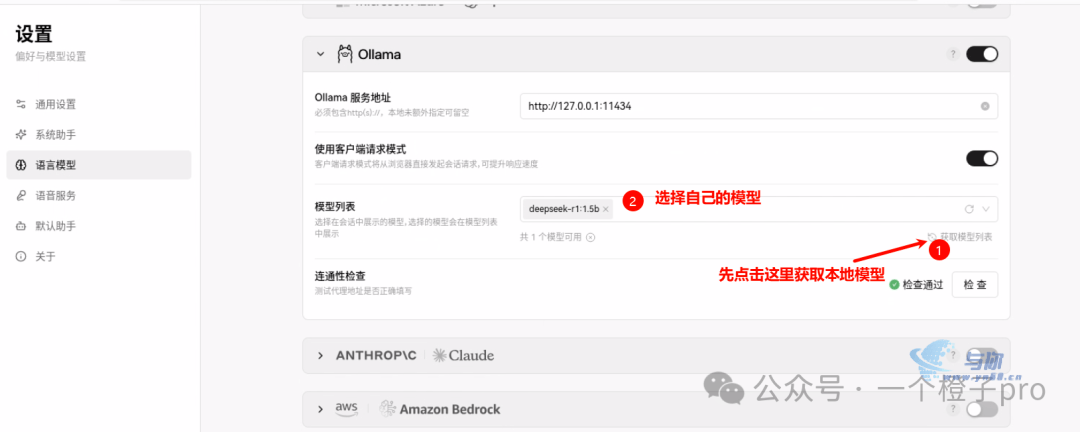

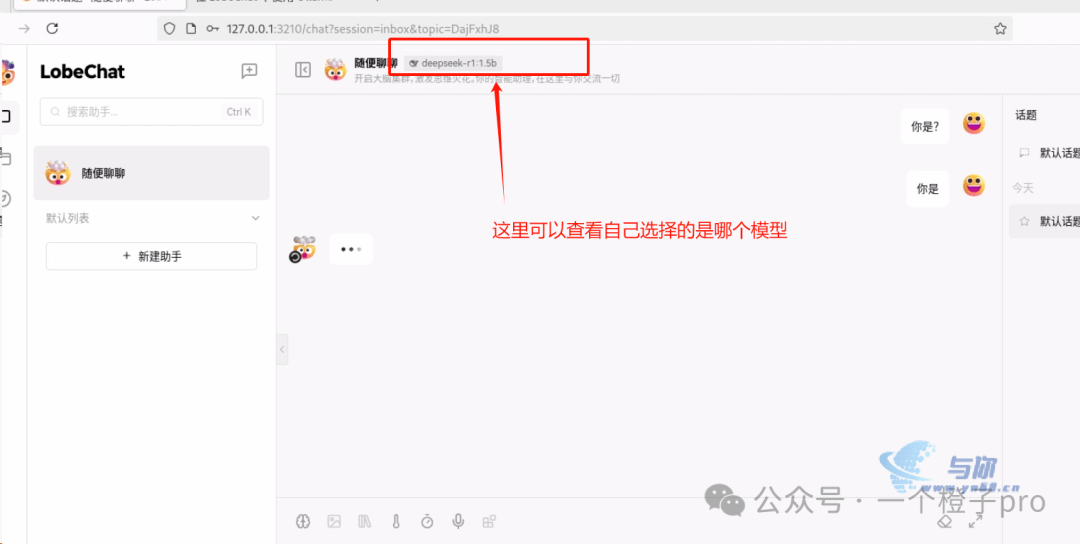

LobeChat对接deepseek-r1

点击lebechat小图像

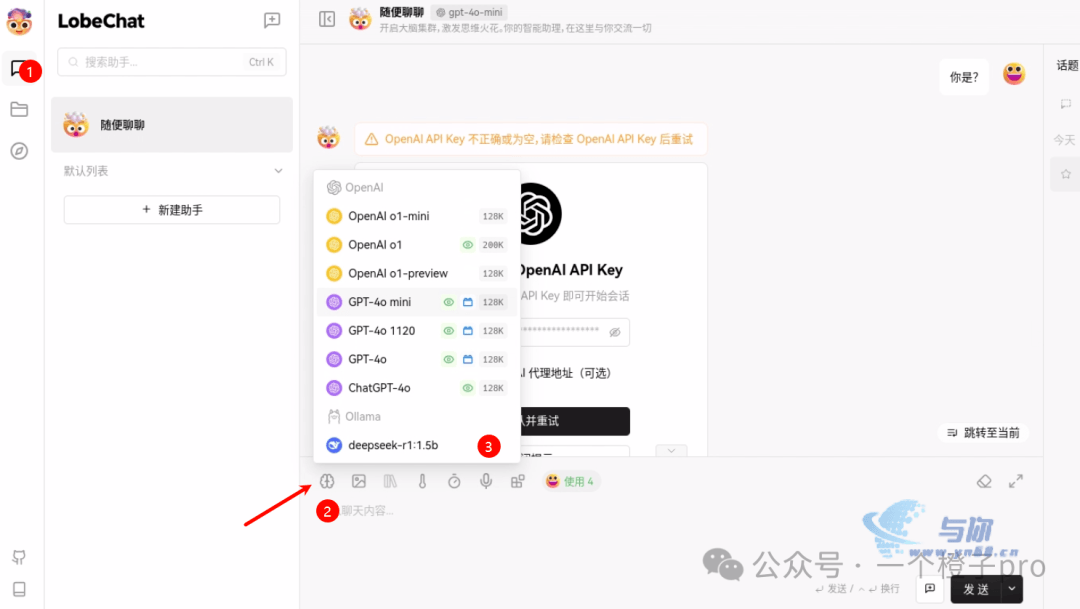

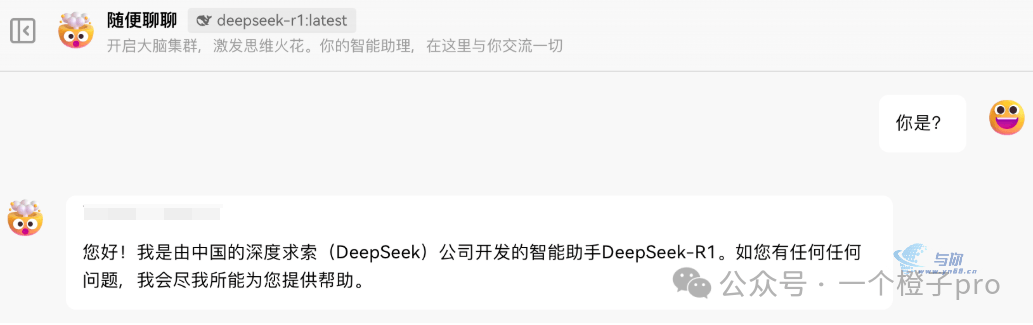

对话框当中选择自己下载的模型

首次问答需要输入密码,密码就是上边compose当中的参数ACCESS_CODE,我们设置的是lobe66

到这里,已经完成了大模型的整个部署过程。